Um diese Frage zu beantworten müssen wir uns mal den Wind anschauen.

Wind ist eine Folge des Ausgleichs zwischen Hoch- und Tiefdruckgebieten, wobei die Corioliskraft eine ganz entscheidende Rolle spielt. Der Klimawandel verändert nun die gewohnten großen saisonalen Windsysteme auf dem gesamten Planeten. Im Schlepptau dessen werden Extremwetter wie Dürren oder Starkregen auch in Regionen wie Mitteleuropa immer wahrscheinlicher, die bislang eher davon verschont waren. In der Arktis steigen die Temperaturen deutlich schneller als in allen anderen Klimazonen und deshalb sind gerade dort die Antworten auf viele Fragen zu finden.

Atlantische Hurrikans entwickeln sich schon seit eh und je zunächst in tropischen Zonen nahe dem Äquator und bewegen sich dann regelmäßig in Richtung Ostküste der USA, wo sie ganze Landstriche verwüsten. Doch dies geschieht nun weitaus öfter, intensiver und zu sogar außerhalb der typischen Hurrikan-Saison.

Über der gesamten Nordhalbkugel sorgen die steigenden Temperaturen dafür, dass das wichtige Windsystem „Nordpolar-Jetstream“, das sich in ungefähr zehn Kilometern Höhe befindet, ins Schlingern gerät. Dessen Winde sausen nahezu laminar mit bis zu 500 km/h von Westen nach Osten um das riesige Nordpolargebiet.

Doch in den letzten Jahren schwächelt dieser Luftstrom und das hat Folgen, insbesondere für Europa. Herbe Dürreperioden, wie sie das Jahr 2018 mit sich brachte, und Regenkatastrophen, wie sie uns beispielsweise der Sommer 2021 beschert hat, werden zukünftig immer öfter auftreten. Verursacht wird das Ganze in der Arktis, weil dort die Temperaturen schneller steigen als überall sonst auf dem Planeten.

Der Klimawandel ändert die Winde und die veränderten Windsysteme beschleunigen ihrerseits den Klimawandel, das ist ein klassischer Teufelskreis, den wir unbedingt durchbrechen müssen, denn alles hängt mit allem zusammen. Im Pazifik zum Beispiel war in den letzten Jahren eine geradezu tödliche Warmwasserblase zu beobachten.

Was hat es mit dem Blob auf sich?

Ungefähr seit der Jahrtausendwende gibt es vor der nordamerikanischen Westküste immer wieder verheerende Hitzewellen, die als „Blob“ bezeichnet werden. Zuletzt kostete ein solches dreijähriges Ereignis (2019 bis 2021) Abertausenden Walen, Robben und Seevögeln das Leben. Das Wissenschaftler-Team um Armineh Barkhordarian von der Uni Hamburg hat sich dieses Phänomens angenommen.

Der Blob nimmt auf dem Pazifik eine Fläche von bis zu drei Millionen Quadratkilometern ein. Die Wassertemperatur liegt in diesem riesigen Areal bis zu sechs Grad Celsius über dem langjährigen Durchschnitt, viel zu warm für so viele Tiere. Außerdem begünstigt das warme Wasser eine giftige Algenblüte, die dem Wasser viel Sauerstoff entzieht.

Dass der Temperaturanstieg auf menschengemachte Treibhausgase zurückzuführen ist, ist nach Aussage der Wissenschaftler so gut wie sicher. Während des vergangenen Vierteljahrhunderts ist die Wassertemperatur im nordöstlichen Pazifik in jedem Jahr um durchschnittlich 0,05 °C angestiegen. In der Folge haben sich die Hochdruckgebiete im Winter über dem Wasser verstärkt, das heißt, die Wolkenbildung ist reduziert, sodass die Sonne das Meer nahezu ungehindert erwärmen kann, und zwar etwas mehr als die nächtliche Abstrahlung an Wärme-Energie abzieht.

Seit der Jahrtausendwende traten über 30 Hitzewellen im Pazifik auf, wodurch die Ökosysteme dramatisch belastet wurden und die Biodiversität massiv bedroht ist. Wird dabei eine kritische Schwelle überschritten, ist eine Erholung prinzipiell nicht mehr möglich.

Auch frühere Studien haben bereits aufgezeigt, dass Blob-Ereignisse durch den Klimawandel zukünftig ungefähr 20-mal wahrscheinlicher auftreten. Tatsächlich wären die Folgen katastrophal, sollte es auf unserem Planeten insgesamt um „nur“ drei Grad wärmer werden.

An düsteren Vorwarnungen zu diesem Thema hat es das Intergovernmental Panel on Climate Change (IPCC) im Rahmen seiner bislang 14 Sonderberichte nicht mangeln lassen. Dennoch veröffentlichte das Fachjournal PNAS im März 2022 seine „Perspektive“ unter dem Titel „Klima-Endspiel“.

Hans Joachim Schellnhuber, Gründer des Potsdam-Instituts für Klimafolgenforschung (PIK), und Johan Rockström, gegenwärtiger PIK-Chef, werfen dem Klimarat und überhaupt den Entscheidungsträgern auf dieser Welt vor, sich um die alles entscheidende Frage herumzudrücken, die da lautet:

Kann der vom Menschen gemachte Klimawandel zum Zusammenbruch der Gesellschaften und sogar zum endgültigen Aussterben der Menschheit führen?

Dass der Klimarat vergleichsweise moderate Töne anschlägt, liegt sehr wahrscheinlich daran, dass er nicht der Panikmache bezichtigt werden möchte. Immerhin ist er darauf angewiesen, in seinen Formulierungen einen Konsens mit mehr als 190 Staaten zu finden. Es gibt aber noch einen gewichtigeren Grund: Würde der Klimarat jetzt schon deutlich höhere Temperaturen in Aussicht stellen, dann würde das proklamierte Ziel der Begrenzung der Erderwärmung auf 1,5 Grad ad absurdum geführt werden. „Wenn alles egal ist“, braucht sich niemand mehr bemühen.

Die von zunehmender Hitze betroffenen Länder in Nordafrika und am Persischen Golf sind zum einen sehr dicht besiedelt und zum anderen politisch besonders instabil, was große Gefahren birgt. Die zu erwartenden sozialen und politischen Folgen tangieren zwei Atommächte und zurzeit insgesamt sieben Hochsicherheitslabors, die die gefährlichsten Krankheitserreger enthalten. Der Weg in die Katastrophe hat viele Facetten, nicht nur Hitze, Stürme, Starkregen, Erdrutsche oder das Verschwinden ganzer Inselketten.

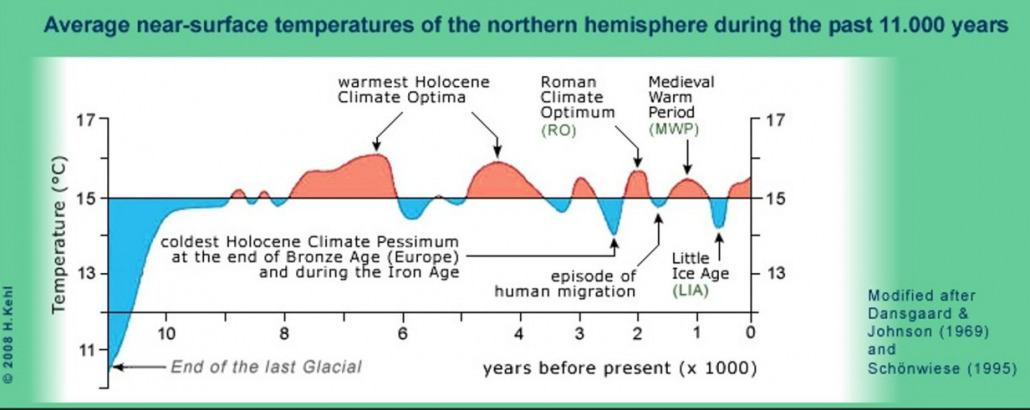

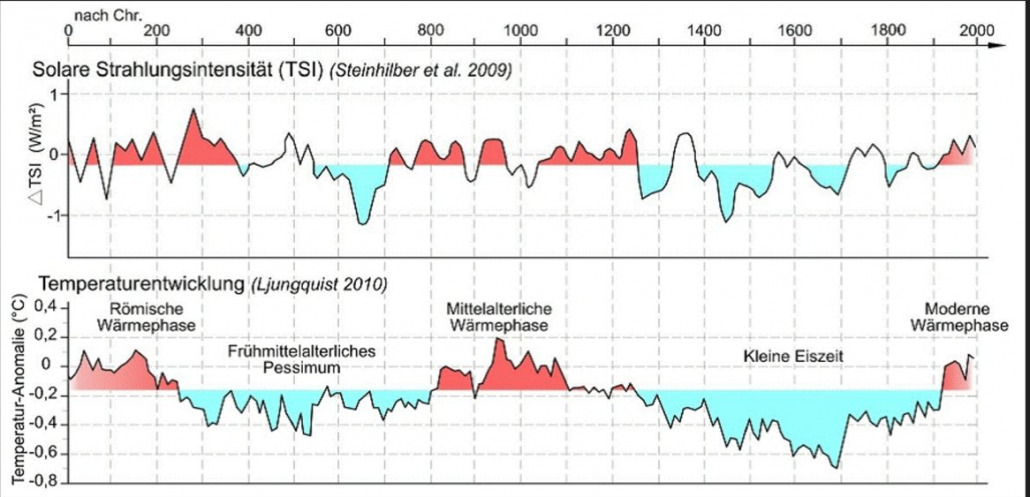

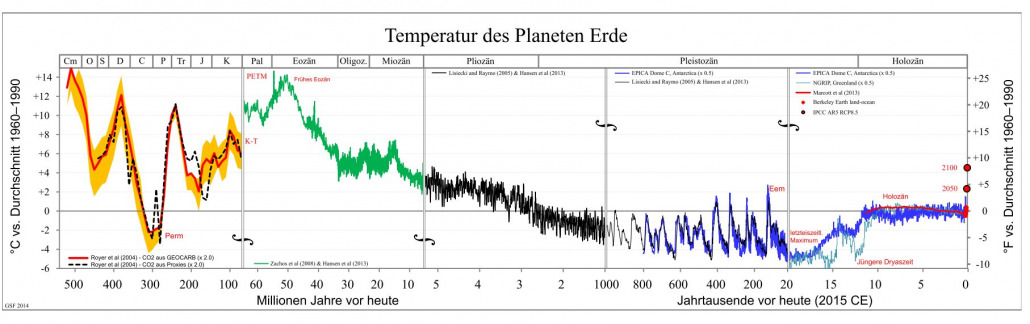

Wenn es in der Erdgeschichte zu einem Massenaussterben kam, war stets ein massiver Klimawandel daran beteiligt. Ganze Imperien sind nachweislich dadurch zugrunde gegangen und unsere empfindliche moderne Zivilisation ist mit Sicherheit noch weniger dagegen gefeit.

Dieser Beitrag wurde am 22.08.2022 erstellt.